El uso de vídeos ultrafalsos, conocidos como deepfakes, con contenido sexual explícito ha experimentado un aumento significativo en el último año siendo las principales víctimas de esta prácticas, mujeres que se ven involucradas en estos videos generados con inteligencia artificial en contra de su voluntad.

Según el reciente estudio ‘State of deepfakes 2023’, que resalta la creciente tendencia de montajes sexuales, con un aumento del 464% en el último año y realizado por la empresa de ciberseguridad Home Security Heroes, también destaca que «el 99% de las víctimas de deepfakes pornográficos son mujeres».

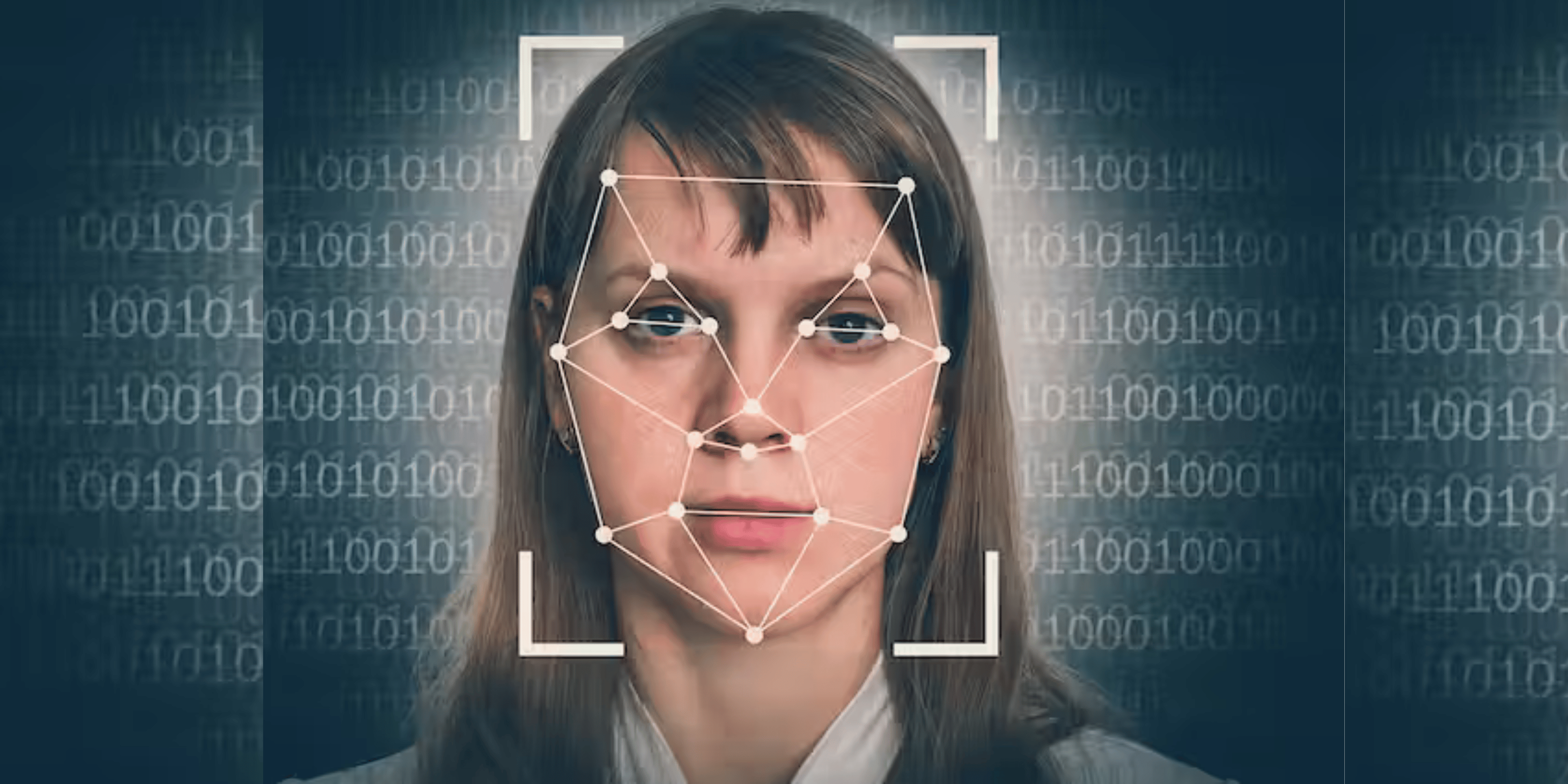

Hay que explicar que los deepfakes son vídeos altamente falsificados que se caracterizan por su gran realismo al mostrar imágenes que parecen auténticas, al superponer millones de fotografías de una persona en un vídeo grabado por un actor o actriz. El Instituto Nacional de Ciberseguridad (INCIBE) advierte que estos contenidos son manipulados para hacer creer a los espectadores que una persona está haciendo declaraciones o acciones que en realidad nunca ocurrieron.

Los deepfakes se crean utilizando herramientas o programas de inteligencia artificial que permiten cambiar rostros en imágenes y modificar la voz.

Un fenómeno en aumento con impacto selectivo, como se recoge en la metodología del estudio ‘State of deepfakes 2023’, está basado en la recopilación de datos de acceso público en sitios web y foros. Se analizaron vídeos de los diez principales sitios web de contenido para adultos, así como 85 canales especializados en deepfakes en plataformas como YouTube, Vimeo y Dailymotion.

El estudio revela que «la cantidad total de vídeos deepfake ha aumentado en un 550% desde 2019 hasta 2023, alcanzando un total de 95,820 contenidos visuales altamente falsificados. De estos, el 98% son deepfakes pornográficos». Además, se destaca que «siete de los diez principales sitios web de contenido para adultos albergan deepfakes».

Otra conclusión importante del estudio es que la producción de vídeos ultrafalsos de contenido sexual no es uniforme, sino selectiva. Esta forma de suplantación de identidad atenta contra la privacidad de las personas, pero no afecta a todos por igual. Se observan sesgos relacionados con el género, la nacionalidad y la profesión.

Sabemos que el 99% de las víctimas son mujeres, pero es relevante mencionar que Corea del Sur es el país más afectado por este fenómeno, con una tasa de susceptibilidad del 53% de ser objeto de este tipo de contenido para adultos. Además, el 94% de las personas que aparecen en estos vídeos provienen de la industria del entretenimiento, siendo las cantantes las principales víctimas, seguidas de actrices e influencers.

La democratización de las herramientas de inteligencia artificial, principal causa del aumento de este tipo de contenido, no es aleatorio. Si antes la creación de manipulaciones convincentes requería experiencia y conocimientos técnicos, ahora (con los avances tecnológicos y la facilidad de acceso) han contribuido a la creciente tendencia de producir contenidos altamente falsificados.

Plataformas con interfaces gráficas intuitivas, comunidades y aplicaciones gratuitas han facilitado la creación de contenido ultrafalso, desde simples cambios de rostros hasta manipulaciones de vídeo más complejas.

Actualmente, según este estudio, existen alrededor de «15 sitios web y foros de comunidades de creación de deepfakes». De estas herramientas, «al menos una de cada tres» permite a los usuarios generar contenido para adultos utilizando técnicas basadas en la inteligencia artificial.

Esto significa que en menos de 30 minutos, es posible crear un vídeo pornográfico altamente falso de 60 segundos de cualquier persona usando solo una imagen de su rostro sin costos significativos.

Una práctica común sin regulación específica El estudio ‘State of deepfakes 2023’ incluye una encuesta realizada a 1,522 hombres estadounidenses entre el 15 de julio y el 29 de agosto de 2023, que señala que «el 48% de los encuestados han consumido pornografía deepfake al menos una vez». Otro dato relevante de la encuesta es que el 74% de estos usuarios afirman no sentirse culpables por consumir pornografía deepfake.

Estos montajes pornográficos generados con inteligencia artificial se han convertido en una de las principales formas de violencia digital hacia las mujeres. Esta práctica viola dos derechos fundamentales: la protección de datos y la privacidad, así como la intimidad, la honra y la propia imagen.

La creación de imágenes sexuales con inteligencia artificial no se considera un delito específico en el Código Penal.

Por ello, desde Somos Más, te recomendamos seis pasos basados en el asesoramiento legal y psicológico necesario ante este tipo de violencia digital:

- Conserva las imágenes

- No interactúes

- Busca apoyo en tu círculo de confianza

- Denuncia

- Busca apoyo psicológico

- Infórmate sobre las instituciones que pueden ayudarte.

Fuente Verifica RTVE

Deja tu comentario